요즘 핫한 LLM 딥시크, 적은 비용으로 챗지피티 성능을 따라잡았다고 하는데요.

딥시크는 중국의 인공지능 회사가 개발한 오픈소스 LLM 모델로,

적은 비용, 오픈된 코드, 높은 성능을 키워드로 여러 빅테크 기업들에 충격을 안겨줬죠.

딥시크에는 크게 두 가지 모델이 있어요.

V3와 R1입니다.

- V3: 자연어 처리를 위해 개발한 LLM

- R1: V3을 기반으로 좀 더 복잡한 추론(코딩, 수학 풀이 등)을 위해 개발

하지만 개발 회사가 중국이라는 사실에 개인정보 유출과 보안 취약점에 대한 우려가 커졌는데요,

저도 웹에서 돌려보기는 찝찝하더라구요.

그래서 개인적으로 궁금하여 R1을 맥북에서 돌려봤습니다.

제 맥북 사양은 512G, 48G RAM이었어요.

상세 과정과 결과를 보여드릴게요.

OLLAMA 설치

https://ollama.com/ 에 접속해서 OS에 맞는 버전을 다운로드합니다.

설치 후에 deepseek를 검색합니다.

deepseek-coder, deepseek-v3, deepseek-r1이 있는데 램 용량에 맞춰 원하는 모델을 선택하면 됩니다.

같은 모델에서도 램 용량에 따라 드롭다운으로 여러가지 버전을 선택할 수 있습니다.

저는 deepseek-r1 70b까지 돌릴 수 있을 것 같았지만,

램 용량이 48G인데 40G까지 필요해서 그냥 32b까지만 돌려보았습니다.

ollama를 설치하라는 문구는 그냥 무시해줘도 됩니다.

테스트용 LLM인데 2G나 잡아먹어요.

저는 궁금하니까 설치해봤어요.

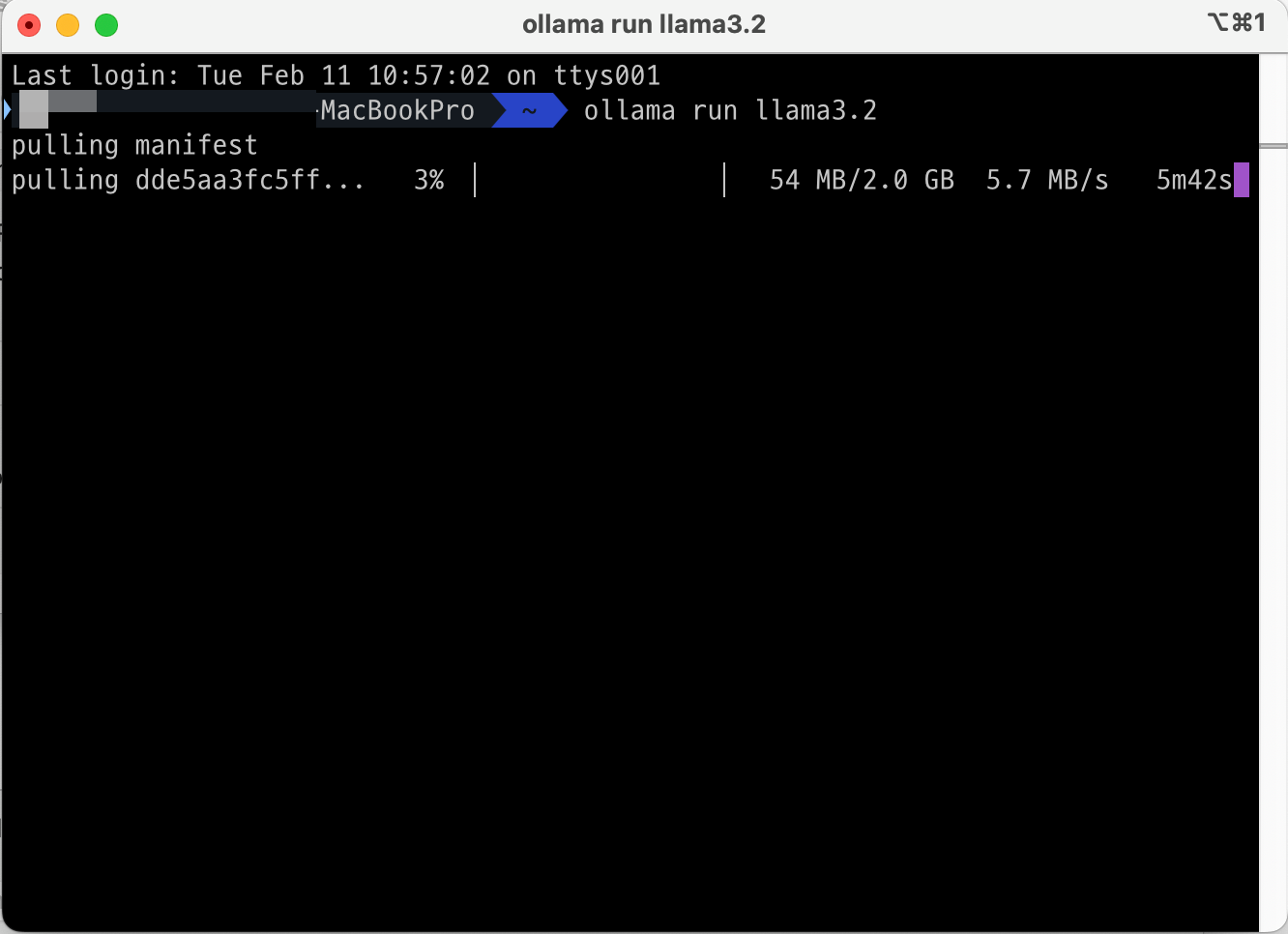

모델 설치 방법은 터미널을 켜고 ollama run ~ 을 입력해주면 됩니다.

한국어 성능은 구립니다.

모델 설치

이제 주 목적인 deepseek-r1:32b를 설치해줍니다.

아래 명령어만 터미널에 입력해줍니다. 매우 간단해요!

ollama run deepseek-r1:32b

테스트 결과

와이파이가 느려서 약 1시간 만에 설치가 완료되고 테스트 해보았습니다.

한국어로 물어봐도 영어로 답변하고, 일본어와 중국어가 섞여있어 아직 한국말은 잘 못 하는 것 같습니다.

외국어를 제외한 답변의 퀄리티는 32b임에도 훌륭한 것 같습니다.

실무에서 개인 PC로 유료 지피티를 대체하고 쓰기에는 무리가 있어 보입니다.

'AI engineering > LLM' 카테고리의 다른 글

| 이 ChatGPT는 스스로 마인크래프트를 합니다. - LLM, AI agent (0) | 2024.12.30 |

|---|---|

| [LLM] ChatGPT, Claude, Gemini 같은 LLM이란? 초보도 쉽게 알기 (1) | 2024.12.28 |

| [LLM, RAG] 테이블 데이터를 LLM 프롬프팅에 사용하기 (1) | 2024.12.26 |